La e-santé mentale est en plein essor. Systèmes d’information, consultations à distance, e-learning, objets connectés et réseaux sociaux nous apportent, aujourd’hui, des outils numériques au service de notre bien-être psychique. Parmi eux, les chatbots, ou agents conversationnels, se développent à vitesse grand V.

Pas de long délai pour avoir un rendez-vous, pas de salle d’attente, ni de psy en face de soi. Assis devant son ordinateur, ou au fond de son lit, avec son smartphone, on peut contacter un « thérapeute » virtuel pour lui parler de ses troubles du sommeil, de son anxiété ou de sa dépression. Une alternative sérieuse aux psy ? Clairement, non. Il ne faut pas se méprendre sur le rôle des chatbots – ou agents conversationnels -, dont le principal objectif est d’apporter un soulagement et des conseils aux personnes en situation de détresse psychologique, qui cherchent un moyen d’apaiser une crise passagère ne nécessitant pas de prise en charge urgente.

Pourquoi créer de tels outils ?

Avec le manque de psychologues, pointé durant la pandémie de Covid-19, et le coût des consultations, pas toujours remboursées, la crainte de nombreuses personnes en souffrance psychologique de passer pour un « fou » et de s’exposer à la critique, dans une société où les troubles mentaux sont encore largement source de discrimination, sont les principaux freins à une consultation psychologique.

L’intelligence artificielle serait une réponse, au moins partielle, à ces résistances. Palliant en partie le manque de psy, donnant accès à une « consultation » aux personnes qui n’en ont habituellement pas les moyens, elle pourrait convaincre ceux qui n’oseraient pas franchir le pas de porte d’un professionnel de santé de s’en remettre à un robot, même s’il est encore bien éloigné des androïdes de nos films de science-fiction. Seul derrière son écran, « face » à une entité neutre, disponible et dénuée de tout sentiment, la peur d’être jugé s’estomperait, estime la psychologue Alison Darcy, de l’Université de Stanford aux Etats-Unis, co-créatrice de Woebot, la première application à utiliser l’intelligence artificielle basée sur les méthodes de la thérapie cognitivo-comportementale, couramment utilisée par les psychologues pour traiter l’anxiété et la dépression. Woebot se présente comme un « thérapeute automatisé lorsque trouver un vrai thérapeute peut sembler une impossibilité logistique et financière (et) vise à utiliser le traitement du langage naturel et les réponses apprises pour imiter la conversation, se souvenir des sessions passées et donner des conseils sur le sommeil, l’inquiétude et le stress ».

Pour le chercheur en sciences sociales et épistémologie Xavier Briffault, ces dispositifs sophistiqués sont des amorces « de psychothérapie à distance et automatisée » permettant « des interventions personnalisées et des techniques de thérapie cognitive et comportementale bien structurée ». Ils pourraient se révéler efficaces en première approche d’une psychothérapie et pour accompagner les personnes en souffrance entre deux rendez-vous chez le psy, selon les créateurs de l’application française Mon Sherpa. D’après les premières études universitaires (en anglais), le chatbot Woebot permettrait effectivement une réduction des symptômes dépressifs, ce qui va dans le sens des études prouvant que les thérapies cognitivo-comportementales effectuées par internet, parfois sous forme de jeux vidéo, peuvent être aussi efficaces que celles délivrées par un thérapeute.

A l’usage

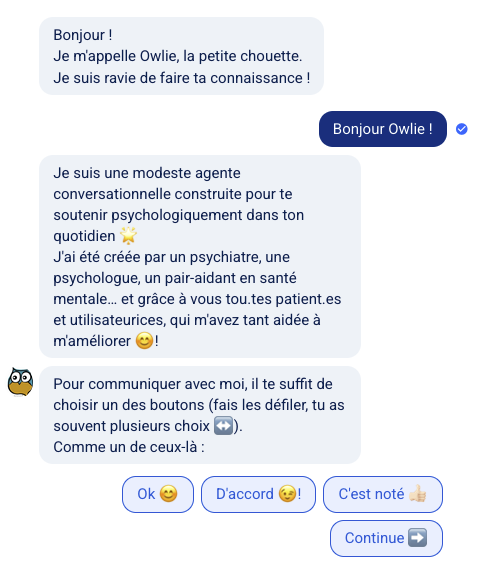

Le chatbot français Owlie, est un des outils numériques “pertinents dans la lutte contre l’épidémie” du Ministère de la Santé. Développé bénévolement, l’application a pour objectif affiché « de mettre à disposition des outils de psychologie et de psychothérapie pour tou•te•s » sans volonté de se substituer au suivi par des professionnels de santé. J’ai décidé de la tester pour me faire une idée.

Owlie, la petite chouette de soutien psy.

Owlie, la petite chouette de soutien psy.L’avatar du robot Owlie, une petite chouette aux grands yeux écarquillés, commence par se présenter en précisant bien qu’elle n’est qu’un robot : inutile d’essayer de lui écrire directement, elle ne comprendra pas. Elle me demande ensuite mon prénom, ou plus précisément la manière dont je souhaite être appelé. Sous couvert d’anonymat, il peut être plus facile de de se « confier ». Je choisi John pour ce test et me mets dans la peau de quelqu’un qui se sent seul et démuni face à des pensées sombres à la suite d’un événement traumatisant : la tentative de suicide d’un ami proche.

Premier contact avec Owlie

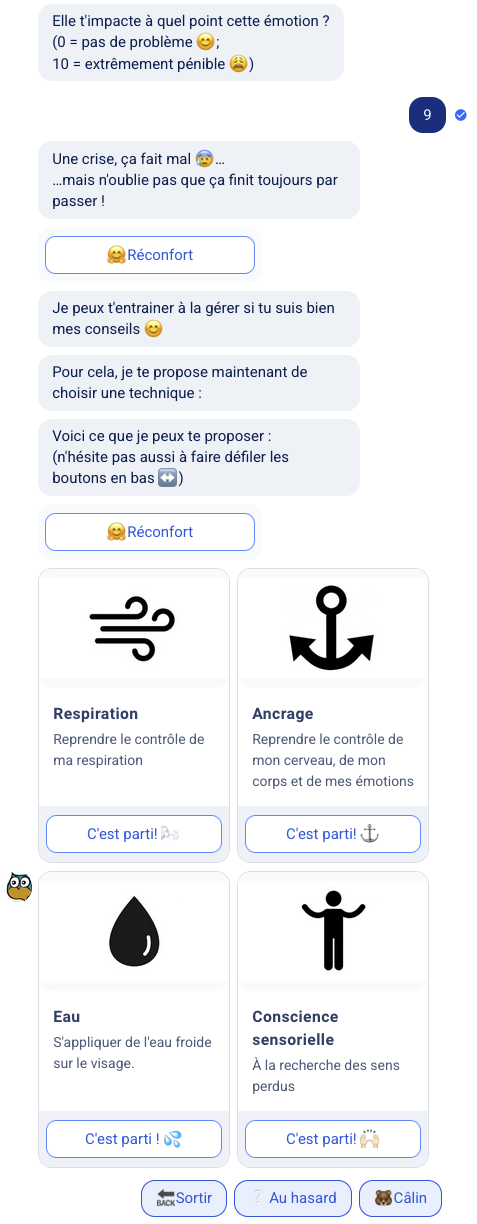

Premier contact avec OwlieA la question d’Owlie, sous forme de choix multiples, je réponds donc vouloir parler d’un évènement. Puis, à sa demande de précision, j’écris : « un ami a tenté de se suicider ». Owlie me propose alors de choisir une émotion parmi une liste fermée : heureux, content, apaisé, calme, cela ne me fait rien, fatigué, triste, coupable, dégoûté, stressé, énervé. Je choisi « coupable », précisant que ce sentiment a un impact extrêmement pénible, soit 9 sur une échelle de 1 à 10.

Owlie me propose alors un menu crise, composé de plusieurs techniques pour m’aider : respiration, ancrage, eau et conscience sensorielle. Le choix « eau » consiste à mettre son visage sous l’eau froide ou à appliquer quelque chose de froid sur les yeux ou les joues tout en retenant sa respiration pendant 15 ou 20 secondes. Le choix « respiration » oriente vers un exercice qui ressemble à la cohérence cardiaque. L’ancrage émotionnel m’invite à penser à l’avenir proche et à écrire la première chose que je voudrais faire après cette crise passée, la première personne que je souhaiterais voir, et ce que j’ai prévu de faire pendant les jours qui suivent. Je réponds « voyager », « ma mère » et « je ne sais pas ». « Concentre-toi sur ces évènements prévus » me propose Owlie, « essaye d’imaginer la manière dont ils pourraient se dérouler et comment ils te changeront les idées. Prends ton temps pour bien visualiser ! Tu as complété ce niveau ! »

Owlie propose des solutions.

Owlie propose des solutions.La « séance » pourrait s’arrêter là, mais Owlie me propose de faire le point, ce que j’accepte, car je ne suis « toujours pas top », selon les termes d’un des boutons cliquables. J’indique que je souhaite remédier à la situation et « agir en direct ». Cela fait déjà une quinzaine de minutes que j’échange avec Owlie, qui me demande : 1/si je suis en pleine crise, 2/ si j’ai de mauvaises pensées, 3/ si j’ai besoin de me poser. Je choisis les « mauvaises pensées », conformes à ma demande du début, et précise que « j’ai été traumatisé et me sens responsable ».

Owlie reconnait ses limites.

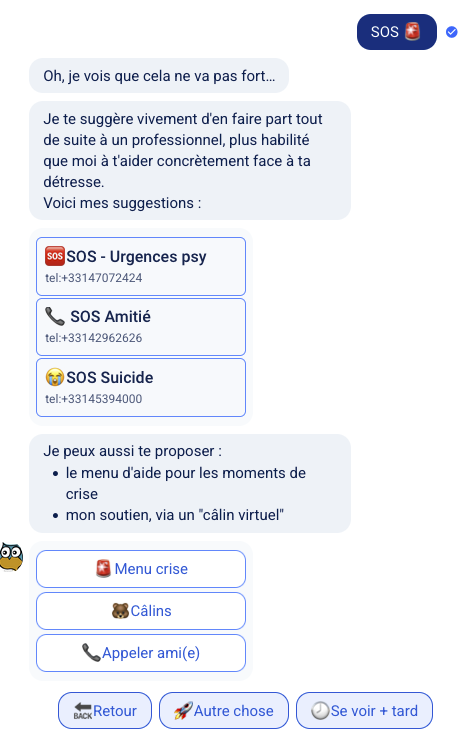

Owlie reconnait ses limites.Après quelques généralités sensées me rassurer (« On ressent souvent de la honte ou de la culpabilité après avoir vécu un traumatisme. Aussi paradoxal qu’il puisse paraitre, ce phénomène est « normal » ») Owlie affiche de nouveaux exercices et un bouton SOS sur lequel je clique. Une série de numéros de téléphone (SOS Urgence psy, SOS Amitié, SOS Suicide) apparaît.

D’abord étonné que le chatbot ne réagisse pas plus rapidement au suicide évoqué au début de l’échange (« un ami a tenté de se suicider »), je me suis demandé si la formulation avait été, en quelque sorte, comprise par le robot : je n’étais pas moi-même en danger, et la situation ne nécessitait pas de SOS urgent. J’ai renouvelé l’expérience en tapant simplement « suicide » quand Owlie m’a demandé de quel événement je souhaitais parler. La réponse a été immédiate : « Je te suggère vivement d’en faire part tout de suite à un professionnel, plus habilité que moi à t’aider concrètement face à ta détresse. Voici mes suggestions : SOS – Urgences psy, SOS Amitié, SOS Suicide ». Une réponse complétée par la possibilité d’ouvrir le menu crise, d’appeler un ami ou d’imaginer des situations positives et réconfortantes.

Une révolution à ses débuts

Les chatbots proposent des techniques permettant de se sentir mieux et d’acquérir une certaine autonomie dans la gestion d’un trouble psychologique passager ou modéré. Ils accompagnent la prévention et le traitement des symptômes légers, mais « ne comprennent pas le sens du langage humain » et n’ont pas d’affects, rappellent les psychologues. Leur intelligence toute relative les cantonne, pour le moment, à ne « comprendre » que des situations simples, faciles à interpréter. Parfois, leur incapacité à répondre de manière pertinente donne l’impression d’être écouté sans être compris, ce qui pourrait potentiellement augmenter l’angoisse. Leur empathie artificielle (« Je comprends, parfois on a juste envie d’appuyer sur « OFF » quelques temps pour souffler »), peut être agaçante, mais elle est sans doute nécessaire pour beaucoup d’utilisateurs, rassurés par cette prise en main, ou attirés par la dimension « ludique » et par la fausse impression d’ « intelligence » de l’outil. L’expérience deviendra certainement beaucoup plus agréable lorsque ces chatbots seront capable de parler d’une voix « naturelle », comme une équipe de l’Université de Bordeaux s’y est essayée avec Louise, la psychologue virtuelle à la belle voix synthétique de Kanopée, une application de compagnons virtuels sortie pendant le confinement pour aider aux problèmes de sommeil, d’addiction et de stress.

Sans contester l’utilité et l’efficacité de ces outils, on peut se demander dans quelle mesure ils contribueront à renforcer la désincarnation de nos échanges, de nos relations, et à altérer notre socialité, à un moment où les scientifiques nous alertent sur les danger du numérique et de l’usage immodéré des écrans. Le psychologue David Monnier estime que les chatbots tendent à « instaurer un lien spécial à la machine, non sans résonance divine, et à restaurer une forme de confession ». Pour le psychiatre Serge Tisseron, « avec nos « chatbots », nous allons développer une tendance à nous raconter en permanence. […] du coup, la notion de solitude changera : la compagnie ne se définira plus seulement par la présence d’un humain, mais aussi d’une machine. Que deviendra la possibilité de se tenir à soi-même un discours intérieur, sans interlocuteur, lorsque nous serons habitués à en avoir un à demeure, prêt à nous écouter aussi longtemps que nous le voudrons ? » Les risques de dissonance cognitive, un phénomène bien connu qui conduit à développer avec une machine « la même relation qu’avec des humains, et croire qu’elles ont des émotions », sont déjà bien réels. Ce thème classique de la science-fiction est d’une actualité passionnante. Les débats éthiques n’en sont qu’à leur début.

Attention, très peu d’applications dédiées à la santé mentale « ont fait l’objet d’études scientifiques rigoureuses montrant leur efficacité et leur fiabilité » rappelle Psycom, qui a adapté les recommandations de l’Association américaine de psychiatrie dans une infographie intitulée « Que vaut votre appli de santé mentale ? ».

Que vaut votre appli de sante mentale ? Un Poster proposé par Psychom, d’après l’Association américaine de psychiatrie. Voir le PDF

Que vaut votre appli de sante mentale ? Un Poster proposé par Psychom, d’après l’Association américaine de psychiatrie. Voir le PDF

Crédits

Illustration : © Adobe Stock